大数据与人工智能是否会摧毁民主?

本文译自 Scientific American 上的英文版,德文版见 Spektrum der Wissenschaft。作者:Dirk Helbing 、Bruno S. Frey 、Gerd Gigerenzer 、Ernst Hafen 、Michael Hagner 、Yvonne Hofstetter 、Jeroen van den Hoven 、Roberto V. Zicari 、Andrej Zwitter。2017 年 2 月 25 日。

「启蒙是人类远离自我强化的不成熟并从中崛起。不成熟是在没人引导时没有理解他人的能力。」

——伊曼努尔·康德《什么是启蒙?》(1784)

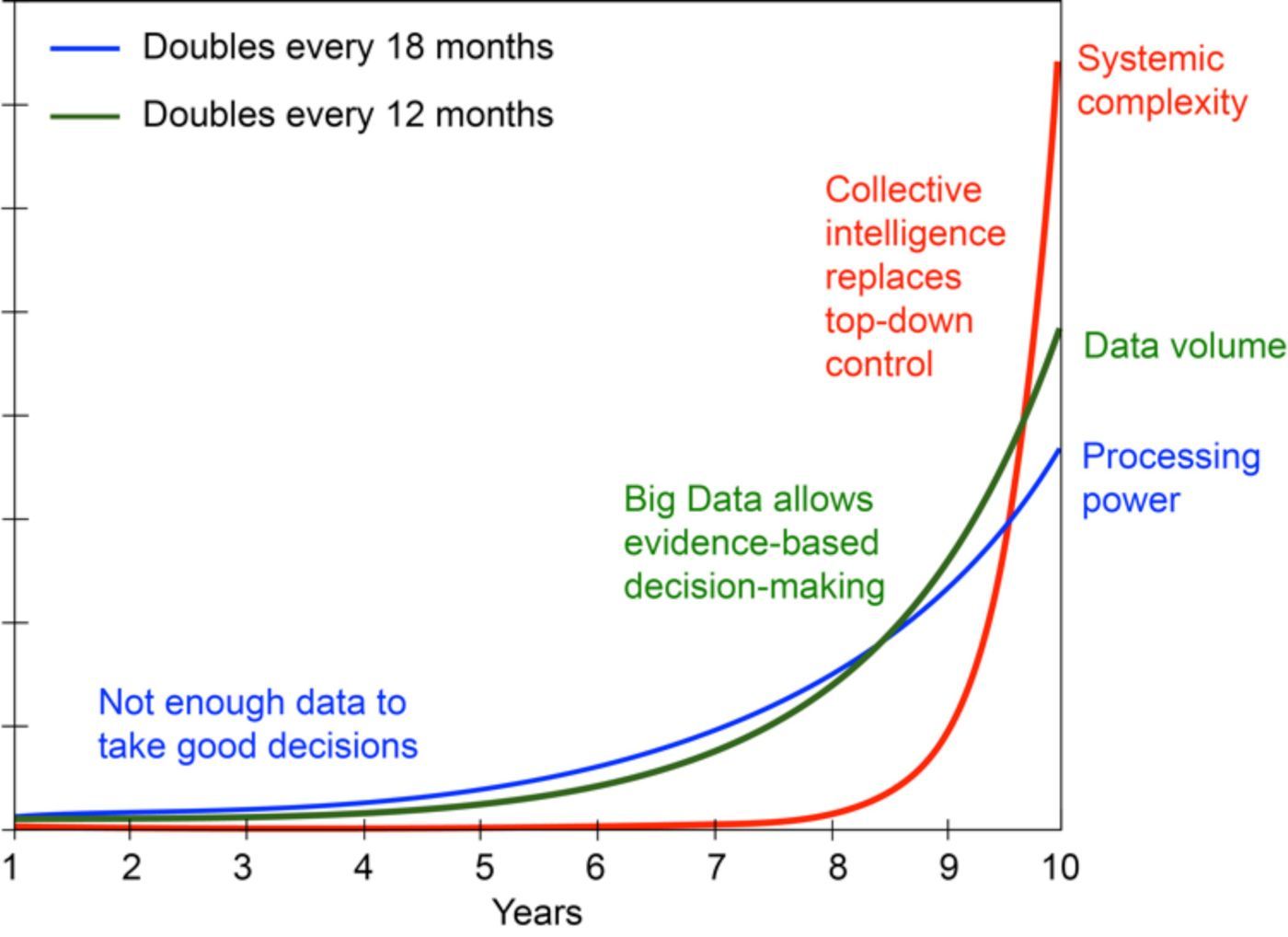

数字革命正在全面开花。这将如何改变我们的世界?我们产生的数据每年都会多一倍。换句话说:2016 年我们产生的数据与直到 2015 年的整个人类历史所产生的数据一样多。每一分钟,我们都会进行数十万次谷歌搜索,发布数十万条 Facebook 帖子。这些数据中包含着能揭示我们所思所感的信息。不久之后,我们周遭的事物(甚至包括我们的衣物)也都会连接到互联网上。据估计,10 年内将会有 1500 亿联网的测量传感器,比地球人口多 20 倍。届时,数据量每 12 小时就会翻番。很多公司已经在尝试用这样的「大数据(Big Data)」赚「大钱(Big Money)」了。

所有的东西都会智能化;很快我们就不仅会有智能手机,还会有智能家居、智慧工厂和智慧城市。可以期待这样的发展会造就智慧的国家和更智慧的星球吗?

事实上,人工智能领域正在取得令人瞩目的发展进步,尤其是其对数据分析自动化的贡献。人工智能不再是一行行写出来的,现在它已经具备了学习能力,因此能够实现持续的自我演进。最近谷歌 DeepMind 开发的算法自己学会了通关 49 个 Atari 游戏。现在的算法在识别手写语言和模式方面几乎已经和人类一样好了,甚至在某些任务上还优于人类。它们也能描述照片和视频的内容。如今,70% 的金融交易都是由算法执行的。一部分新闻内容也是自动生成的。这一切会造成一些重大的经济后果:在未来的 10 到 20 年时间里,今天大约一半的工作都将处于算法的威胁之下。当今的世界 500 强企业中的 40% 都将在十年内消失。

可以预计,超级计算机很快就将在几乎所有领域超过人类能力——大概会在 2020 年到 2060 年之间。专家们已经开始敲打警钟。特斯拉的伊隆·马斯克、微软的比尔·盖茨和苹果公司联合创始人斯蒂夫·沃兹尼亚克等有技术远见的人都警告说超级智能是对人类存在严重的危险,甚至可能比核武器还危险。

这是杞人忧天吗?

有一件事很显而易见:我们的经济和社会组织方式将发生根本性的变化。我们正经历着自第二次世界大战结束以来最大的变革;在生产自动化与创造了自动驾驶汽车之后,接下来就是社会的自动化了。也因此,社会站在了一个交叉路口,未来可能有巨大的机会,也可能存在可观的风险。如果我们做出错误的决定,那就将可能威胁到我们最伟大的历史成就。

1940 年代,美国数学家诺伯特·维纳(1894-1964)发明了控制论。他认为系统的行为可以通过适当的反馈来控制。很快,一些研究者就想象可根据这一基本原理控制经济和社会,但那时候还不存在必需的技术。

如今,新加坡已被视为数据控制型社会的完美范例。一开始为了保护其公民免受恐怖主义侵害的项目计划最终也给其经济和移民政策、房地产市场和学校课程造成了影响。中国也在走类似的路。百度(中国的谷歌)近期邀请了军方参与其「中国脑计划」。这涉及到在收集自用户的搜索引擎数据上运行所谓的「深度学习算法」。除此之外,中国也正计划着某种形式的社会控制。据近期的报道称,每个中国公民都会有一个所谓的「社会信用分」,这将决定他们在哪种条件下可以获得贷款、工作或去其它国家的旅行签证。这种类型的个人监控将包含人民的互联网浏览情况以及他们的社交行为(详见「聚焦中国」一节)。

随着消费者面临着愈见频繁的信用检查,某些网上商店正在实验个性化定价,我们西方在这方面也在向类似的方向发展。我们也越来越明显地看到我们全都站在机构监控的视野正中心。这一情况在 2015 年被披露出来,英国特勤局的「Karma Police」项目被公开,表明他们会全面筛查每个人的互联网使用情况。「老大哥」正在变成现实吗?

程序化社会,程序化公民

所有东西一开始都相当无害。搜索引擎和推荐平台已开始为我们提供产品和服务的个性化建议。这种信息基于收集自之前的搜索、购买和出行行为以及社交活动的个人数据和元数据。尽管正式说来用户的身份是受保护的,但在实践中却可以很轻松地推断出来。如今,算法相当清楚地知道我们做了什么、我们在想什么以及我们的感受——甚至可能比我们的朋友、家人或甚至我们自己都还清楚。很多时候,我们收到的推荐实在太适合了,以至于我们会觉得所得到的结果是我们自己的决定,尽管实际上它们不是我们的。事实上,我们正以这种方式受到比以往任何时候都成功的远程控制。我们被了解得越多,我们的选择就越不可能是自由的,就越可能是由其他人预先确定的。

但问题不止于此。某些软件平台正向「说服式计算(persuasive computing)」发展。未来,这些平台有能力使用复杂精细的操控技术引导我们完成一整套动作,以便执行复杂的工作流程或为互联网平台生成免费的内容,而公司企业则可从中大赚特赚。现在的趋势是从编程计算机向编程人发展。

这些技术在政治世界也日渐流行。在「微推(nudge)」这一标签下,政府正大规模地尝试通过「微推」(这是家长主义的一种现代形式)方法引导公民实现更健康或对环境更友好的行为。这种新式的充满关怀的政府不仅对我们所做的事情感兴趣,而且也想要确保我们做的是它认为正确的事。这里要依赖的神奇魔法就是「大微推(big nudging)」,即「大数据」与「微推」的组合。对很多人来说,这似乎是一种数字权杖,让人可以高效地统治民众,且无需让公民参与到民主过程中。这能够克服既得利益者的阻碍并优化世界的发展吗?如果可以,那么公民可能将处于数据驱动的「明君」的统治下,它将能像数字魔杖一样实现所需的经济和社会成果。

预先编程的灾难

但看看相关的科研文献,其中表明以所谓的「优化」方式控制人们的意见的尝试都注定要失败,因为这个问题非常复杂。意见形成的动态过程充满了变数。没人知道数字魔杖(即操纵性的微推技术)应该以怎样的方式得到最好的使用。什么是好的?什么是坏的?衡量标准往往在事后才变得显而易见。举个例子,在 2009 年的德国猪流感疫情期间,每个人都被鼓励去接种疫苗。但是,我们现在知道一定比例的接种者会患上一种不寻常的疾病——发作性嗜睡症(narcolepsy)。幸运的是,选择接种的人没有变得更多!

另一个例子是医疗保险提供商最近尝试通过发放智能健康手环来鼓励人们更多锻炼,以降低人群中的心血管疾病发病数量;但最终,这又可能导致髋部手术增多。在社会这样的复杂系统中,一个方面的改进几乎不可避免地会导致另一个方面的劣化。因此,大规模干预有时候可能最终成为大规模错误。

不仅如此,罪犯、恐怖分子和极端主义者迟早会尝试夺取这个数字魔杖的控制权——甚至我们可能都注意不到。几乎所有的公司和机构都曾被攻破过,甚至包括五角大楼、白宫和国家安全局(NSA)。

当缺乏足够的透明度和民主控制时,还会出现一个进一步的问题:系统受到来自内部的侵蚀。搜索算法和推荐系统可能受到影响。公司企业可以竞价购买特定的词组,以得到更偏爱的结果。政府也可能有能力影响结果。在选举期间,政府可以微推尚未决定的选民,让他们支持自己——这是一种难以检测的操纵。因此,不管是谁控制了这项技术,都能赢得选举——将他们自己推向权力。

在很多单个搜索引擎或单个社交媒体平台占据了主导市场份额的国家,这一问题还会更加严重。公众可能受到决定性的影响,这些国家也可以被远程干预。尽管欧洲法院于 2015 年 10 月 6 日做出的判决限制了欧洲数据的无限制出口,但这个潜在问题在欧洲范围仍未内得到解决,在其它地方就更别说了。

我们可以预计会出现怎样的不良副作用?为了操纵不被察觉,他们会采用一种所谓的「共振效应(resonance effect)」——为每个个体充分定制的建议。通过这种方式,局部趋势会在重复之中逐渐得到强化,最终导致「过滤气泡(filter bubble)」或「回声室效应(echo chamber effect)」:最终你接收到的所有信息都只是反射回来的你自身的观点。这会导致社会极化,分割为不同的群体,而且这些群体之间无法再互相理解,彼此之间的冲突也与日俱增。个性化信息可能以这种方式无意中破坏社会凝聚力。目前美国政治中就能观察到这一现象:民主党和共和党的分割越来越严重,使得政治妥协变得几乎不再可能。结果就是社会的碎片化,甚至可能引发社会崩溃。

由于共振效应,社会中意见的大规模变化仅能以缓慢和渐进的方式实现。这种效应的发生存在时间延迟,但同样,已经发生的也无法轻易消除。比如,对少数族裔或移民的怨恨可能会失控;过多的民族主义情绪可能导致歧视、极端主义和冲突。

也许更重要的是,操纵方法事实上会改变我们做决定的方式。它们能至少暂时性地掩盖其它相关的文化和社会习惯。总的来说,大规模地使用操纵方法可能导致严重的社会危害,包括在数字世界中采取残忍的行为。谁应该对此负责呢?

法律问题

鉴于过去几年中针对烟草公司、银行、IT 和汽车公司的巨额罚款,这会带来不应被忽视的法律问题。但如果有的话,哪些法律可能会被违反?首先,操纵技术很显然会限制选择的自由。如果对我们的行为的远程控制效果良好,那么我们基本上就会成为数字奴隶,因为我们只会执行实际上由其他人事先做出的决定。当然,操纵技术仅有部分效果。尽管如此,我们的自由还是会慢慢消失,但当然——目前而言,这个速度慢到人们不会有多少抵抗。

伟大的启蒙者伊曼努尔·康德曾给出了与此非常相关的见解。他指出了很多事情,其中之一是试图决定其国民的幸福的国家是暴政国家。然而,个人自我发展的权利只能被有权控制他们的生活的人行驶,而这是以信息自决(informational self-determination)为前提的。这正是我们最重要的宪法权利。除非这些权利得到尊重,否则民主就不能很好地发挥效力。如果这些权利受到了限制,就会危害到我们的宪法、我们的社会和国家。

因为大微推等操纵技术的工作方式与个性化广告类似,所以其它法律也会受到影响。广告必须有一说一,不能有误导性。它们也不允许利用某些心理操纵技术,比如潜意识刺激。这就是禁止在电影中插入一瞬间软饮料广告的原因,因为这样的话广告就不是有意识地感知到的,而可能仍会有潜意识的影响。此外,当前普遍存在的个人数据的收集和处理肯定不符合欧洲国家以及其它一些地方的应用数据保护法。

最后,个性化定价的合法性也值得怀疑,因为这可能是对内部信息的错误使用。其它相关的方面还可能有违反平等和非歧视的原则以及竞争法,因为自由的市场准入和价格透明无法再得到保证。这种情况可类比在其它国家以更低的价格出售产品的企业,但却试图阻止通过这些国家进行购买。这种情况过去曾导致了很高的惩罚性罚款。

个性化广告和定价不同于老式的广告或折扣券,因为后者不是针对性的,也不会侵犯我们的隐私,不会利用我们的心理弱点以及剥夺我们的批判性思考。

此外,我们还不要忘记,在学术界,即使最无害的决策实验都被认为是以人类为受试者,这必须得到公众所能依靠的道德伦理委员会的批准。在每个案例中,受试人员都被要求表明知情并同意。相反,单次点击来确认我们同意上百页的「使用条款」协议的内容(现在很多信息平台都使用了这种模式)是非常不合适的。

尽管在学术界是这样,但微推等操纵技术却能对数百万人执行实验,而且不会告知他们,没有透明也没有道德伦理限制。甚至 Facebook 等大型社交网络或 OkCupid 等在线约会平台都已经公开承认进行着这样的社会实验。如果我们想要避免对人类和社会的不负责任的研究(只要想想看之前有心理学家参与了实施酷刑),那么我们就亟需强制施行高标准,特别是科学质量标准和类似于希波克拉底誓言的行为准则。

我们的思想、我们的自由、我们的民主都已经沦陷了吗?

我们假设存在这样一个超智能机器,它具有神一般的知识和超人类的能力:我们会遵照它的指令吗?这似乎是可能的。但如果我们这样做,那么伊隆·马斯克、比尔·盖茨,斯蒂夫·沃兹尼亚克、斯蒂芬·霍金等人发出的警告就会变成现实:计算机将接管这个世界。我们必须清楚地认识到超智能也可能犯错、撒谎、追求自私利益或被操纵。最重要的是,它可能比不上整个群体的分散的集体智慧。

用计算机集群来替代所有公民的思考的想法是很荒唐的,因为这会极大降低可实现的方案的多样性和质量。我们已经可以很明显地看到,尽管近来数据显著增多而且还使用了个性化的信息,但这个世界的问题却没有减少——相反!世界和平很脆弱。气候的长期变化可能导致自恐龙灭绝以来最严重的物种损失。我们还远没有克服金融危机及其对经济的影响。据估计,网络犯罪每年会造成 3 万亿美元损失。国家和恐怖分子也都在为网络战争做准备。

在一个飞速变化的世界中,超智能可能永远无法给出完美的决策(见图 1):系统复杂度的增长速度快于数据量的增长,而数据量的增长速度又快于数据处理能力的发展,而数据传输速度又有限。这会导致系统忽视局部的知识和事实,而这对于实现优秀的解决方案而言又很重要。分布式的局部控制方法往往优于中心化的方法,尤其是在行为高度可变、难以预测而且无法实时优化的复杂系统中。这在城市的交通控制中已经成为了现实,对于我们高度网络化、全球化的世界的社会和经济系统而言,问题还会更甚。

此外,还存在一种危险:通过强大的算法来实现决策操纵有可能破坏「集体智慧」的根基,而集体智慧往往能灵活地适应我们这个复杂世界的挑战。要让集体智慧发挥效力,个体的信息搜索和决策必须独立进行。但是,如果我们的判断和决策是由算法预先确定的,那么这实际上会造成对人的洗脑。智慧的存在会降格为单纯的指令接收者,只是自动响应刺激而已。

换句话说:个性化信息在我们周围构建了「过滤气泡」,这是一种囚禁我们的思想的数字监狱。在这样的情况下,创造力和「跳出盒子」思考何以可能实现?最终,技术官僚式行为的中心化系统以及使用超智能信息系统的社会控制会导向一种新形式的独裁统治。因此,在「家长制自由主义(liberal paternalism)」旗帜下的自上而下控制的社会原则上不过是一种带着好看面具的极权主义政权。

事实上,大微推的目标是将很多人的行为约束到规范内并操纵他们的观点和决定。这会将其置于政治宣传的舞台中央,目标是通过行为控制剥夺公民的能力。我们认为其长期后果是致命的,尤其是考虑到上面提到的危害文化的影响时。

更好的数字社会是可能的

尽管全球竞争激烈,但民主国家的明智做法是不要把多个世纪以来的成就抛弃。与其它政治制度相比,西方民主国家的优势在于他们已经学会了应对多元化和多样性。现在它们只需要学习如何更多地利用它们。

未来,这些国家将在企业、政府和公民之间找到一个健康的平衡。这需要网络化的思维方式以及建立信息、创新、产品和服务的「生态系统」。为了实现良好的效果,不仅创造参与的机会很重要,而且还要支持多样性。因为我们没有办法确定最好的目标函数:我们应该优化人均国民生产总值还是可持续性?权力还是和平?幸福还是预期寿命?通常情况下,只有在事实发生后,我们才能知道哪个更好。通过允许追寻各种不同的目标,一个多元化的社会能够更好地应对可能出现的各种意料之外的难题。

中心化的、自上而下的控制是过去的方案,这只适合复杂度低的系统。联邦制度和多数议决是现在的方案。随着经济和文化的发展,社会复杂度也会继续提升。未来的方案是集体智慧。这意味着公民科学、众包和在线讨论平台是提供更多知识、思想和资源的非常重要的新方法。

集体智慧需要高度多样化。但是,如今的个性化信息系统正在削弱多样化,并且这一趋势正在加强。

社会多样性与生物多样性一样重要。这不仅有助于集体智慧和创新,还能为社会提供弹性——即我们的社会应对意外冲击的能力。降低社会多样性往往还会降低经济和社会的机能和表现。这就是极权主义政权经常与邻国发生冲突的原因。社会多样性降低的典型长期后果是政治不稳定和战争,这种情况在历史长河中屡见不鲜。因此,多元化和参与权不应被视为对公民的让步,而应被看作是繁荣、复杂、现代的社会的功能性先决条件。

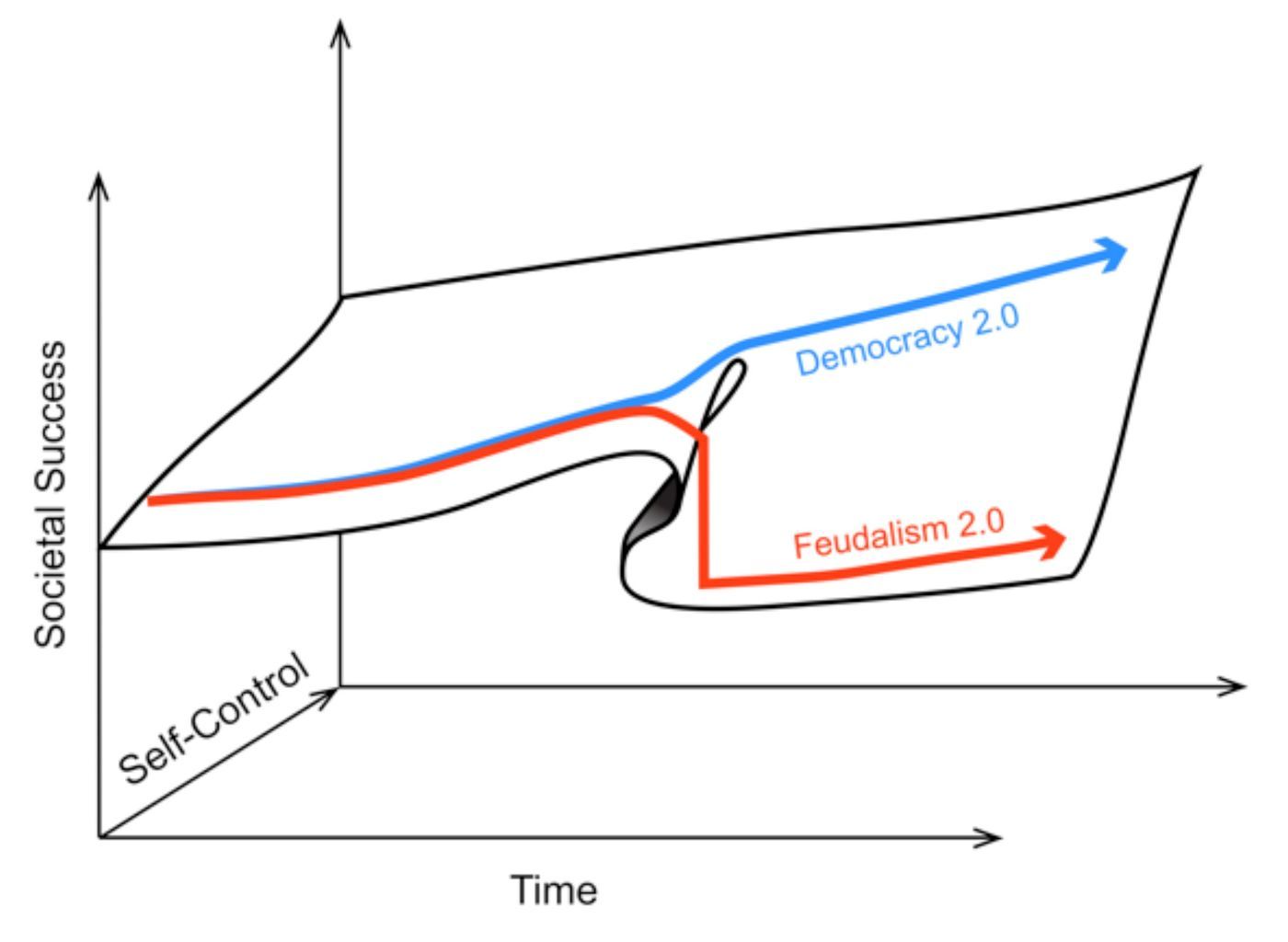

总体而言,可以说我们现在正站在一个交叉路口(见图 2)。大数据、人工智能、控制论和行为经济学正在塑造我们的社会——无论是让这个社会更好或更坏。如果这些广泛使用的技术与我们社会的核心价值观不兼容,那么它们迟早会造成广泛的破坏。它们可能造就具有极权特征的自动化社会。在最糟糕的情况中,中心化的人工智能会控制我们所知所想,还会控制我们的行为方式。我们正处在这样一个历史性时刻,是时候必须决定正确的道路了——这条道路将能让我们受益于这场数字革命。因此,我们敦促遵守以下基本原则:

- 进一步分散信息系统的功能;

- 支持信息自决和参与;

- 提升透明度以获得更好的信任;

- 减少信息的扭曲和污染;

- 启用用户可以控制的信息过滤技术;

- 支持社会和经济多样性;

- 提升互操作性和改善合作协同的机会;

- 创建数字助理和协调工具;

- 支持集体智慧;

- 通过数字认知教育和启蒙来促使公民在数字世界中进行负责任的行为。

遵循这一数字政策,我们都将能从这场数字革命的成果中受益,不管是经济、政府、公民,还是其它。我们还在等什么?

一个应对数字时代策略

大数据和人工智能无疑是重要的创新。从个性化医疗到可持续城市,它们具有催化经济价值和社会进步的巨大潜力。然而,使用这些技术来剥夺公民的能力是完全不可接受的。大微推和公民信用分会中心化地滥用所收集到的个人数据,以一种本质上极权主义的方式进行行为控制。这不仅与人权和民主原则不相容,而且也不适用于管理现代的创新型社会。为了解决这个世界的真正问题,需要信息和风险管理领域提出远远更好的方法。负责任创新的研究领域以及「Data for Humanity」倡议能为大数据和人工智能应该如何被用于造福社会提供指导。

现在我们能做什么?首先,即使在数字革命的这个时代,公民的基本权利也应得到保护,因为这些基本权利是现代的实际可行的民主社会的基本前提。这需要在信任与合作的基础上创造一种新的社会契约,它不会将公民和客户视为障碍或可以利用的资源,而是将他们视为伙伴。为此,国家必须提供合适的监管框架,确保以符合民主的方式设计和使用这些技术。这必须要保证信息自决,而且不仅是理论上的保证,而且还要实际得到确保,因为这对我们而言是一种以自决和负责任的方式生活的先决条件。

我们应该有权获得收集自我们的个人数据的副本。法律应当规定,这个信息必须以一种标准化格式自动发送到个人数据存储位置,个人可以借此管理对他们的数据的使用情况(可能得到某些特殊的基于 AI 的数字助理的支持)。为了确保更好的隐私以及防止歧视,法律必须惩罚对数据的无授权使用。然后,个人要有能力决定谁可以使用他们的信息、用于什么目的以及使用多长时间。此外,还必须采取适当的措施来确保数据的存储和交换安全。

考虑多个指标的复杂精细的信誉系统可能有助于提升我们决策所基于的信息的质量。如果数据过滤器以及推荐和搜索算法可由用户选择和配置,那么我们就可以从不同的角度检查问题,我们就更不容易受到失实信息的操纵影响。

此外,我们需要为公民提供有效的投诉程序以及对违反规则的有效制裁。最后,为了实现足够的透明和信任,领先的科学机构应当充当目前逃避民主控制的数据和算法的受托人。这也要求有适当的行为准则,这些行为准则至少必须被有权访问敏感数据和算法的人遵守——这是一种针对信息技术从业者的希波克拉底誓言。

此外,我们还需要一个数字议程,以为新的工作和数字社会的未来打基础。每年我们都向农业和公共基础设施、学校和大学投入数十亿美元——以造福工业和服务业。

因此,我们需要哪些公共系统来确保数字社会取得成功?第一,需要全新的教育理念。应当更重视批判性思维、创造力、创新力和创业精神,而不是制造标准化的工人(这些工人未来的任务将由机器人和计算机算法完成)。教育还应让人理解如何负责任地以及批判性地使用数字技术,因为公民必须清楚地了解数字世界与物理世界互相影响的方式。为了让公民能有效且负责任地行驶自己的权利,他们必须理解这些技术,知道怎样使用是合适的。因此,科学、工业、政治和教育机构都更需要广泛地提供这些知识。

第二,需要有可参与的平台,这能让人更容易成为自雇者、设立他们自己的项目、寻找合作伙伴、向全世界推广产品和服务、管理资源以及纳税和为社会保障做贡献(一种向所有人共享的经济)。为了让这方面做得更好,城镇甚至乡村都可设立新兴数字社区中心,新想法可以在这里免费得到共同发展和测试。在这些中心发现的开放和创新方法的推动下,可以促进大规模的协作式创新。

特定类型的竞赛可以为创新提供额外的动力、有助于提高公众的认知度以及为参与式的数字社会创造发展动力。它们在动员民间社会方面尤其有用,可以确保当地为解决全球性的问题做贡献(比如通过「气候奥运会」的形式)。举个例子,以协调稀缺资源为目标的平台可以帮助释放循环和共享经济的巨大潜力,而这方面目前仍发展有限。

有了开放数据策略的承诺,政府和行业将越来越多地将数据提供给科学和公共用途,从而为有效的信息和创新生态系统创造条件,以紧跟我们这个世界的挑战。这可以通过减税来激励,类似于某些国家通过减税来激励人们使用对环境友好的技术。

第三,建立由公民运行的「数字神经系统」可为每个人开启新的物联网(Internet of Things)机会,并为所有人提供可用的实时数据观测。如果我们希望以更可持续的方式使用资源以及减慢气候变化的速度,那么我们就需要测量我们与其他人以及环境交互时的正面和负面副作用。通过使用适当的反馈回路,系统可以通过自组织的方式被施加影响,进而实现所需的结果。

为了成功实现这一点,我们需要各种激励和交换系统,并将其提供给所有经济、政治和社会创新者。这可以创造出全新的市场,并由此为新的繁荣奠定基础。通过多元化的金融体系(例如功能差异化的货币)以及用于补偿创新发明的新规则,将推动数字经济那近乎无限的潜力得到释放。

为了更好地应对我们的未来世界的复杂性和多样性并将其转变为一个优势,我们将需要个人数字助理。这些数字助理也将受益于人工智能的发展。可以预见,未来将会根据需要灵活地构建和配置许多结合人类智慧与人工智能的网络。但是,为了让我们保有对自己生活的控制权,应该以一种分布式的方式控制这些网络。尤其是要让人们能根据需要登入或退出。

民主平台

「文化维基百科(Wikipedia of Cultures)」最终可以帮助协调高度多样化世界中的各种活动,并使它们相互兼容。它将使世界文化中隐含的成功原则变得显而易见,这样它们就能以新的方式结合起来。像这样的「文化基因组项目(Cultural Genome Project)」也会是某种类型的和平项目,因为它也会提升公众对社会文化多样性价值的认识。全球的公司早就知道,文化多样化和多学科的团队会比同质化团队更成功。但是,有效地整理很多人的知识和想法需要一种框架才能创造出集体智慧,而这个框架在许多地方仍还缺乏。为了改变这一点,提供在线的商议平台将会非常有用。它们还能创造出实现升级的数字民主所需的框架,同时为公民提供更多参与机会。这是很重要的,因为当今世界面临的很多问题都只能通过民间社会的贡献来管理。

聚焦中国:未来的社会看起来就像这样吗?

行为和社会控制将如何影响我们的生活?目前正在中国施行的社会信用分能让我们一窥一二。在中国,所有公民都在一个一维评分指标下被评级。他们所做的每件事都会影响到自己分数的增减。这种做法的目标不仅是大规模监控。这个分数还依赖于个人在互联网上的点击情况以及他们是否政治正确的行为,这个分数能决定他们的信用条件、特定工作的权利以及旅行签证。因此,这个社会信用分关乎行为和社会控制。即使朋友和熟人的行为也会影响这一分数,即也应用了家族连带责任的原则:每个人同时变成了美德的卫士和窥密的线人;思考非正统思想的人会被孤立。如果这种类似的原则在民主国家得到普遍应用,那么不管是国家政府还是有影响力的公司设定了这些规则,最终都无关紧要了——在这两种情况下,民主的支柱都将面临直接的威胁:

- 跟踪和衡量所有会留下数字痕迹的行为都会导致公民变得「赤身裸体」,他们的人格尊严和隐私会逐渐受到侵蚀。

- 决策将不再是自由的,因为来自政府或公司角度的定义该评分系统标准的错误选择会产生负面的后果。原则上讲,个体的自主权将被剥除。

- 每个小错误都会受到惩罚,没有人不被怀疑。无罪推定原则将被淘汰。预测性警务(Predictive Policing)甚至将导致对还未发生(仅仅是预计会发生)的违规行为施加惩罚。

- 由于底层算法不能完全保证不出差错地运作,所以公平和正义的原则会被一种新形式的任意评估所替代,人们也几乎无法针对它为自己辩护。

- 如果个人的目标是外部设定的,那么个人自我发展的可能性会被消除,由此民主多元化也会被消除。

- 地方的文化和社会规范将不再是适当的、依赖具体情况的行为的基础。

- 使用一维的目标函数控制社会会导致更多冲突,并由此损害社会安全。可以预见这会导致严重的不稳定,正如我们在我们的金融体系中看到的那样。

这样的社会控制会将自我负责的公民转变为作为奴才(underling)的个人,导向封建主义 2.0(Feudalism 2.0)。这与民主价值观截然相反。因此,现在是启蒙 2.0(Enlightenment 2.0)的时候了,它将以数字自决为基础,催生出民主 2.0(Democracy 2.0)。这需要民主的技术:与民主原则兼容的信息系统。否则,它们将摧毁我们的社会。

扩展阅读

ACLU: Orwellian Citizen Score, China's credit score system, is a warning for Americans, http://www.computerworld.com/article/2990203/security/aclu-orwellian-citizen-score-chinas-credit-score-system-is-a-warning-for-americans.html

Big data, meet Big Brother: China invents the digital totalitarian state. The worrying implications of its social-credit project. The Economist (December 17, 2016).

Harris, S. The Social Laboratory, Foreign Policy (29 July 2014), http://foreignpolicy.com/2014/07/29/the-social-laboratory/

Tong, V.J.C. Predicting how people think and behave, International Innovation, http://www.internationalinnovation.com/predicting-how-people-think-and-behave/

Volodymyr, M., Kavukcuoglu, K., Silver, D., et al.: Human-level control through deep reinforcement learning. In: Nature, 518, S. 529-533, 2015.

Frey, B. S. und Gallus, J.: Beneficial and Exploitative Nudges. In: Economic Analysis of Law in European Legal Scholarship. Springer, 2015.

Gigerenzer, G.: On the Supposed Evidence for Libertarian Paternalism. In: Review of Philosophy and Psychology 6(3), S. 361-383, 2015.

Grassegger, H. and Krogerus, M. Ich habe nur gezeigt, dass es die Bombe gibt [I have only shown the bomb exists]. Das Magazin (3. Dezember 2016) https://www.dasmagazin.ch/2016/12/03/ich-habe-nur-gezeigt-dass-es-die-bombe-gibt/

Hafen, E., Kossmann, D. und Brand, A.: Health data cooperatives—citizen empowerment. In: Methods of Information in Medicine 53(2), S. 82–86, 2014.

Helbing, D.: The Automation of Society Is Next: How to Survive the Digital Revolution. CreateSpace, 2015.

Helbing, D.: Thinking Ahead—Essays on Big Data, Digital Revolution, and Participatory Market Society. Springer, 2015.

Helbing, D. und Pournaras, E.: Build Digital Democracy. In: Nature 527, S. 33-34, 2015.

van den Hoven, J., Vermaas, P.E. und van den Poel, I.: Handbook of Ethics, Values and Technological Design. Springer, 2015.

Zicari, R. und Zwitter, A.: Data for Humanity: An Open Letter. Frankfurt Big Data Lab, 13.07.2015. Zwitter, A.: Big Data Ethics. In: Big Data & Society 1(2), 2014.

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐